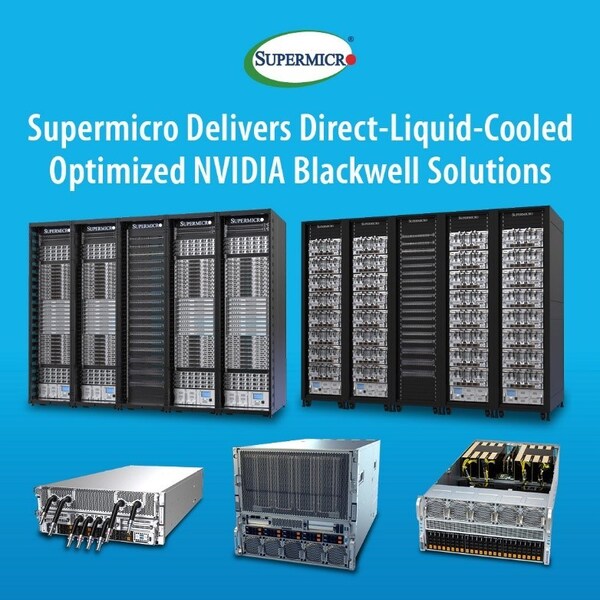

Supermicro的SuperCluster配备了NVIDIA HGXTM B200 8-GPU、NVIDIA GB200、NVL4和NVL72系统,提供升级的AI计算密度

加州圣何塞和亚特兰大2024年11月22日 /美通社/ -- Supermicro, Inc. (NASDAQ:SMCI)为AI、云端、存储和5G/边缘领域的全方位IT解决方案提供企业,宣布推出高性能的SuperCluster。这一端对端AI数据中心解决方案采用NVIDIA Blackwell平台,专为兆级参数规模的生成式AI时代所设计。全新SuperCluster将可大幅增加液冷机架中的NVIDIA HGX B200 8-GPU系统数量,与Supermicro目前领先业界的搭载NVIDIA HGX H100和H200的液冷型SuperCluster相比,GPU计算密度得到大幅提升。此外,Supermicro正在扩大其NVIDIA Hopper系统产品组合,以应对加速型HPC应用和主流企业级AI技术的快速普及。

Supermicro总裁兼首席执行官梁见后(Charles Liang)表示:"Supermicro 拥有必要的专业技术、交付速度和产能,有能力部署包含100,000个GPU的全球最大液冷AI 数据中心项目,而通过Supermicro与NVIDIA的协作,该项目最近刚完成部署。这些Supermicro SuperCluster能通过高效直接液冷(DLC)技术降低电力需求。同时,我们现在推出了采用NVIDIA Blackwell平台的解决方案。通过建构组件(Building Block)技术,能快速设计搭载NVIDIA HGX B200 8-GPU的服务器,并自由搭配液冷或气冷散热配置。我们的SuperCluster提供空前的密度、性能和效率,为未来更密集的AI计算解决方案奠定基础。Supermicro的计算集群搭配直接液冷技术,可帮助整个数据中心实现更高的性能和更低的功耗,并降低运营成本。"

欲了解更多信息,请访问:www.supermicro.com/hpc。

经验证的大规模AI性能:Supermicro NVIDIA HGX B200系统

升级后的SuperCluster可扩充单元采用机架级设计,具有创新垂直冷却液分配歧管(CDM),可使单一机架内的计算节点数量增加。新开发的高效散热冷板和先进的软管设计可进一步改善液冷系统效率。适合大型部署的新型In-Row式冷却液分配装置(CDU)亦可被纳入计算集群的散热配置内。传统气冷数据中心也能运用搭配新型气冷系统机箱的全新NVIDIA HGX B200 8-GPU系统。

全新Supermicro NVIDIA HGX B200 8-GPU系统相较于前一代,提供了多项升级。这些新系统包含对散热和电源方案的优化,并支持双500W Intel® Xeon® 6(配备DDR5 MRDIMM,传输速度达8800 MT/s)或AMD EPYCTM 9005系列处理器。而全新气冷式10U机型Supermicro NVIDIA HGX B200系统则采用经重新设计的机箱,具有更佳的散热空间以支持8 个1000W TDP Blackwell GPU。这些系统在GPU搭配NIP的架构上采用1:1比例设计,并支持NVIDIA BlueField®-3 SuperNIC或NVIDIA ConnectX®-7 NIC,可在高性能计算结构内进行扩充。此外,每个系统所配备的两个NVIDIA BlueField-3数据处理器(DPU),能使附加型高性能AI存储装置之间的数据传输处理效率得到提升。

采用NVIDIA GB200 Grace Blackwell超级芯片的Supermicro解决方案

Supermicro亦提供搭配所有NVIDIA GB200 Grace Blackwell超级芯片的解决方案,包括最新发布的NVIDIA GB200 NVL4超级芯片和NVIDIA GB200 NVL72单机架百万兆级计算机。

Supermicro的NVIDIA MGX系列设计将支持NVIDIA GB200 Grace Blackwell NVL4 超级芯片。这款超级芯片启动了融合式高性能计算与AI的未来,并通过NVLink-C2C技术,以及四个由NVIDIA NVLink™ 连接的Blackwell GPU与两个NVIDIA Grace™ CPU,提供了革命性的性能。这些超级芯片与Supermicro的液冷型NVIDIA MGX模块化系统兼容,且相较于上一代产品,能为科学计算、图神经网络(GNN)训练和推理应用提供至高两倍的性能。

搭配Supermicro端对端液冷解决方案的NVIDIA GB200 NVL72 SuperCluster能在具有SuperCloud Composer(SCC)软件的单个机架中组成一个百万兆级超级计算机,为液冷数据中心提供全面的监控与管理能力。72个NVIDIA Blackwell GPU和36个NVIDIA Grace CPU皆通过第五代NVIDIA NVLink和NVLink Switch连接,能有效地作为单个强大GPU运行,并拥有高度容量的HBM3e内存集区,以实现低延迟的130TB/s总GPU通讯带宽。

搭载NVIDIA H200 NVL的加速计算系统

Supermicro的 5U PCIe加速计算系统现可搭载NVIDIA H200 NVL,适用于需要弹性配置的低功耗、气冷型企业级机架设计,并能为许多AI和高性能计算工作负载进行加速(无论机体尺寸大小)。NVIDIA H200 NVL能通过NVIDIA NVLink,将最多四个GPU相连,并搭配1.5倍内存容量,以及通过HBM3e得到提高的1.2倍带宽,可实现数小时内的LLM快速微调,同时也提供比前一代快1.7倍的LLM 推理性能速度。NVIDIA H200 NVL亦包含NVIDIA AI Enterprise的五年服务,而NVIDIA AI Enterprise是一个用于开发与部署生产型AI的云端原生软件平台。

Supermicro 的X14和H14 5U PCIe加速计算系统通过NVLink技术支持多达两个4路NVIDIA H200 NVL系统,在单个系统内可搭载8个GPU,提供最高900GB/s的GPU互连传输速度,而每4-GPU NVLink域的组合集区具有 564GB 的 HBM3e 内存。全新PCIe 加速计算系统支持最高10个PCIe GPU,现在也可搭载最新Intel Xeon 6或AMD EPYC 9005系列处理器,能为高性能计算和AI应用提供灵活且多功能的选项。

Supermicro亮相2024年超级计算大会

Supermicro在超级计算大会上展示了完整的AI和高性能计算基础架构解决方案组合,包括用于AI SuperCluster的液冷GPU服务器。通过展位的演讲议程,您可以了解客户、Supermicro专家及我们的技术合作伙伴所介绍的最新突破性计算技术。

欢迎莅临Supermicro在2024年超级计算大会的展位,位于 B厅2531号。